ゴクゴク飲める、Amazonで買えるオススメの水出しアイスコーヒー

GW、いかがお過ごしでしょうか?

GWに突入するあたりから、初夏らしい爽やかな気候になりまして、汗ばむ日も多くなってきました。

これは水出しアイスコーヒーの季節ですね!!

というわけで、今回は私が実際にアマゾンで毎回のように注文しているオススメの水出しアイスコーヒーを書いていきます。

Amazonで買える、オススメの水出しアイスコーヒー

いきなり結論から行きますが、現在Amazonで買えるもので、オススメの水出しアイスコーヒーはこれです。

現在はキーコーヒーの方を飲んでいますが、気分やその場のノリでビーンズトークかキーコーヒーを注文しています。

現在の販売価格を見ると、コスパ的にはキーコーヒーのほうが良いです。

私は焙煎が浅いほうが好きなので、基本的にはキーコーヒーをセレクトしていますが、ちょっと飽きてきたときとかにはビーンズトークです。

水出しアイスコーヒーの作り方(お茶パック)

これらのアイスコーヒーはお茶パック的な形状になっており、水道水、またはミネラルウォーターに一晩つけておくだけでできます。

(私は水道水で作ってしまうことが多いです。アイスコーヒーにするとカルキ臭が飛んで気にならなくなるので)

そのため、基本的には寝る前に専用のボトルに水750ミリリットルとアイスコーヒーのお茶パックを入れて寝ます。

寝る前に作っておけば、朝起きるころには出来ているので、起きがけに一杯のアイスコーヒーをゴクゴクやるという流れです。これが最高なのです。

なお、アイスコーヒーを作るボトルはこれを利用しています。

なお、余談ですが、アイスコーヒーの正式な作り方は水を500mlに一つのお茶パックと表記されていたりしますが、そういうのは無視して750ミリリットルで私は作っています。

アメリカンコーヒー的なノリで、多少薄いほうがごくごく飲めるからです。

お店で売っているようなしっかり濃いアイスコーヒーではごくごくやれません。私はごくごくやりたいのです。あと、あまり濃いとカフェインも一度に大量に摂取してしまい、気持ち悪くなったりもするので注意(あくまで個人の経験談です)

今回選定した水出しアイスコーヒーの味について

ちなみにコーヒーというのは本人の好みが色濃く現れるもの。

例えば深煎りが好きな人に、浅煎りの酸味のあるコーヒーを勧めても、残念な結果になってしまいます。

(ちなみに私は浅煎りの酸味のあるやつが好きです)

今回、上げた2種類の水出しのアイスコーヒーの味ですが、基本的にはオーソドックスな味わいです。

つまり、苦いコーヒーが好きな人にも、酸味のあるコーヒーが好きな私のようなタイプの人にも勧められるような、スタンダードな味わいとなっています。

また、水出し特有のスッキリとした味わい、ごくごく飲めるのどごしの良さが特徴的です。

水出しアイスコーヒーと言えば、やはりゴクゴク飲めるのどごしの良さは重要ですよね。

コスパが断然良い、Amazonで買える水出しアイスコーヒー

一時期、仕事中にスタバの水出しアイスコーヒー(コールドブリューコーヒー)ばかり飲んでいた時期がありました。

あれもごくごく飲めて、味的にも結構好きな感じでした。

さて、スタバで買うのに比べたら、自宅で作る水出しアイスコーヒーのほうが当然コスパは良いです。

そして、今回紹介したAmazonで買える2種類の水出しのアイスコーヒーは、その中でも更にコスパが良いです。

私は夏場はかなりの量の水出しアイスコーヒーを消費するので、このコスパは結構重要視しています。

Amazon以外に目を向けると、カルディや無印良品で売っている水出しアイスコーヒーのパックも美味しいです。

これらの水出しアイスコーヒーもお茶パック的な形状となっており、作り方はさきほどご紹介したとおりとなります。

せっかくなので、料金を比較してみましょう。

無印良品の水出しアイスコーヒーは3袋で¥490

無印良品はパックが3袋で¥490。

ただし、お値段の分、味は美味しいです。

初めて飲んだ時、家庭用なのにこんなに美味いのかと驚いた記憶があります。

また、カフェインレスも同じお値段で用意されているのは嬉しいところ。

お値段は張るものの、時折飲むというのであれば無印良品の水出しアイスコーヒーでもありかもしれません。

カルディの水出しアイスコーヒーは4袋で¥448

カルディは値段的には結構安いかも。

ビーンズトークと比較するなら、カルディの方でもありかもしれない。

もちろん、味も文句なしです。

キーコーヒー 香味まろやか水出し珈琲は16袋で¥1,418

圧倒的にコスパ良いのは、やはりこれですね。

一袋¥100を切るのは安い。味も文句なし。

なので、毎日飲む方はこれ一択でしょう。

ビーンズトーク 水出しコーヒー パック 25袋で¥2,690

カルディとあまり変わらないので、上にも書いたように少量で買いたくて、カルディが近くにあればカルディでも良いかもしれません。

焙煎はキーコーヒーに比べるとやや深め。

大きめの袋に入っており、中にはお茶パック形状のアイスコーヒーが無造作に詰められています。

ちなみに個包装ではないので、そういう部分で気になる方はいるかも知れません。

袋のデザインは可愛らしく、水色を基調としたデザインも夏っぽいので、そういう見た目的な部分も良かったりします。

水出しアイスコーヒーと普通のアイスコーヒーの違い

最後に余談を。

水出しアイスコーヒーと普通のアイスコーヒーの違いですが、世間一般的に水出しでないアイスコーヒーとは、ホットコーヒーと同様のやり方で淹れたコーヒーを氷などで急速に冷まして作ることを指すことが多いです。

この場合、コーヒーの香りやコクがホットコーヒー同様に出るので、味がしっかりある珈琲になるパターンが多いような気がします。

コーヒーの油分などもしっかり抽出されるので、味のボディ的なものもしっかりとあり、飲みごたえのあるものになります。

逆に水出しで作るアイスコーヒーは、水につけておき自然に抽出されるのを待つ、手間のかかる工程を経て作られます。

水出しアイスコーヒーの味の特徴は、スッキリしており、のどごしも良いこと。

なんだかビールみたいな表現ですが、水出しだとコーヒーの油分が抑えられるためか、あっさりとした味わいになる傾向があり、ごくごく飲めるようなアイスコーヒーが出来上がります。

もし実際に味の違いを確認してみたければ、スタバで通常のアイスコーヒーとコールドブリューコーヒーをそれぞれ飲み比べてみるのが良いと思います。結構違います。

ちなみに私は昔、コーヒー専門店でしばらくバイトをしていたことがあります。

そのときはサイフォンでコーヒーを淹れており、そのバイト時にコーヒーの奥深さにハマり、すっかり魅了されました。

そのお店でも水出しアイスコーヒーを提供しており、そのお店では水出しアイスコーヒーを短時間に作るための専用の機械が設置されていました。

水出しアイスコーヒーって作るのが面倒なんだな、と当時は思っていましたが、家庭では冷蔵庫に一晩つけておくことで、この問題は解決します。

実際、私も就寝前のルーティンとしてアイスコーヒーをセットして寝る、というのが組み込まれています。

あさイチにごくごく飲む、できたてのアイスコーヒーにはなんとも言えない魅力があります。

これから暑い夏が来ますが、暑い夏のお供に水出しアイスコーヒーはいかがでしょうか?

Notionのデスクトップアプリが動かないときの対応方法

先日、mac版のNotionのデスクトップアプリが突如動かなくなってしまった。

起動しても画面がずっと真っ白のままで、ローディングアイコンがくるくるしているだけ。

再起動しても何もしても全く動かない状態となってしまっていた。

そういえばTwitterでもツイートしていた。

mac版のnotion起動しない。ずっとくるくるしている。 pic.twitter.com/EO3B9sNHSQ

— Yuki Shindo (@shinshin86) April 30, 2021

この対応方法だが、Notionのメニューにある Reset App & Clear Local Data を押すことで解決した。

この Reset App & Clear Local Data を押すと一度ログアウトした状態となるので、再度ログインすることで無事に問題なく利用できるようになった。

もし同じ問題でお困りの方がいたら参考にしてみてください。

検索順位チェックツールの比較と、無料で使えるSEOツール(検索順位チェックツール)をPythonで自作してみた話

目次

今回の記事は少し長めです。

- 前半が検索順位チェックツールの比較

- 後半が自作の検索順位チェックツールのご紹介となります。

検索順位チェックツールの比較

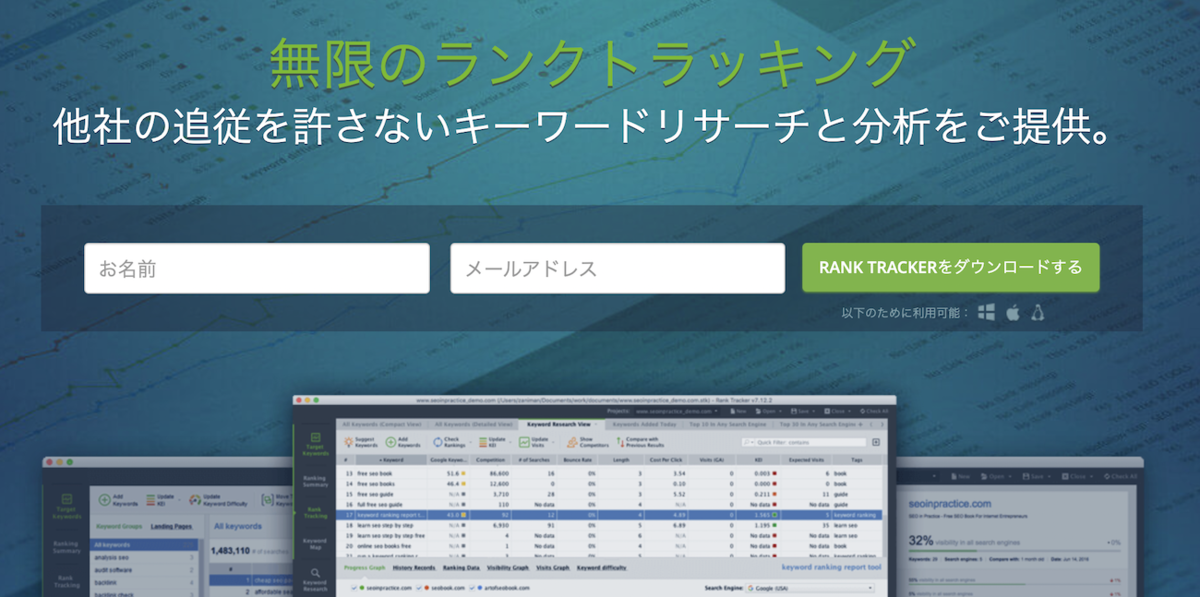

RankTracker

検索順位チェックツールだと有名なクライアントソフトの一つで、Mac環境でも使えるのが魅力的。

そもそも検索順位チェックツールはどのようなシーンで使われるの?

このような検索順位チェックツールはWebマーケターの方やブロガーの方などが利用しています。

基本的にはSEOの改善を行い、検索流入の向上を目指す過程で利用されます。

具体的な作業の流れとしては、

- キーワード選定 2.コンテンツ制作(リライト)

- 公開

- 検索順位のチェック(SEOに関する検証)

- 改善案を作成

- リライト(再び

2に戻る)

そしてこの工程の中の 4. 検索順位のチェック(SEOに関する検証) の作業は、ツールを使うかどうかで大幅に作業効率が異なってくる部分でもあります。

私もここで実際に検索順位チェックツールを作っていく過程で実感しましたが、検索順位チェックは手作業で行っていくと膨大に時間が溶けます。

ただ、自作のツールだと考慮することが多く、やはり実用的かと問われると首を傾けざる終えません。

(小規模に使うなら自作ツールでも問題ありませんが、膨大な量のサイトの検索順位をチェックする場合などは有料のツールを用いたほうが遥かに楽ですし、費用対効果の面でも軍配が上がります)

例えば、こちらのRankTrackerを用いることでこの検索順位チェックの工数を大幅に減らすことで、他の作業に時間と工数を割けるようになるというわけです。

RankTrackerでやれること

- 自サイトの検索順位チェック

- 競合サイトの検索順位チェック

- 競合サイトを登録しておくことで、競合サイト側の検索順位チェックも行えます

- 順位チェックの予約登録

- 順位チェック処理を動かす際の予約が行なえます。要は定時バッチ処理やcron的なことが行えるということですね。

- SEOのチェックキーワードのグループ登録

- カテゴリーごとにまとめたりできます

余談ですが、定時実行は自作のツールでもAWSのlambdaなどから実行しようと一瞬思いましたが、検索順位チェック処理には膨大な時間があるので、すぐに諦めました。毎日実行していたらAWS lambdaの無料枠を超えそうな気がして...

そういう意味でもガッツリ毎日使っていきたいなら検索順位チェックツールはRankTrackerのような有償ツールを使ったほうが良いかもしれません。

RankTrackerの利用料金

RankTrackerは無料から使えます。

ただ、無料は試用版的な立ち位置なので、実際に使うとしたら、個人利用なら年単位で $149 のProfessionalプラン、マーケターやSEOコンサルのようなクライアントワークをするような方であれば、年単位 $349 のEnterpriseプランを利用することになると思います。

ちなみにProfessionalプランで下記のような事ができるようになります。

- プロジェクト毎の競合他社 5社

- プロジェクトの保存(無制限)

- SEOタスクのスケジュール

- Captcha対策用の検索の専用クエリ処理システム

- クリップボードへのデータのコピー

- レポートの印刷(透かし入り)

詳細は上記ページにありますので、ぜひ覗いてみてください。

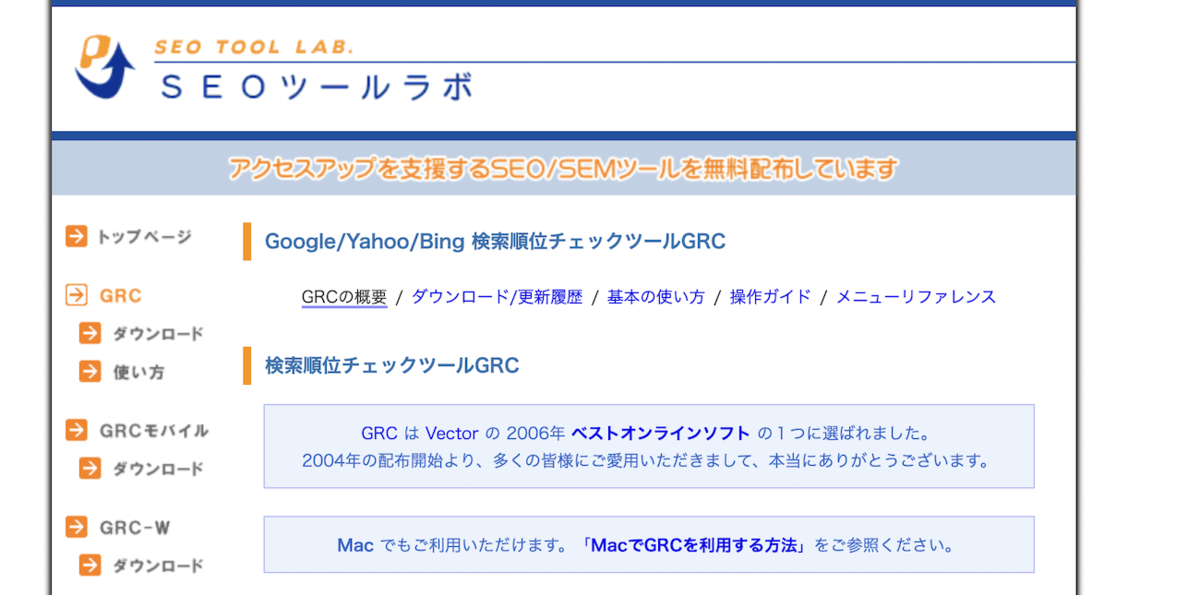

GRC

次はRankTrackerと双璧をなす(?)と勝手に考えている、GRC。

というか日本では、GRCを利用している方のほうが多いような印象を受けます。

GRC、RankTrackerとやれることはそれほど変わらず、料金はお安く、GRC推しの方をよく見る気がします。

GRCでやれること

GRCでやれることですが、

- サイト情報の登録をした上での検索順位チェックの実施

- 検索順位の推移をグラフ表示

- 検索順位チェックの自動実行(指定日時での自動実行)

と、RankTrackerとほぼ同様の内容となっています。

UIデザインは少し前のWindowsアプリといった趣で、決して洗練されたデザインではないですが、これはこれでいかにも玄人向けのツールと言った雰囲気が漂っていて、私は嫌いではありません(笑)

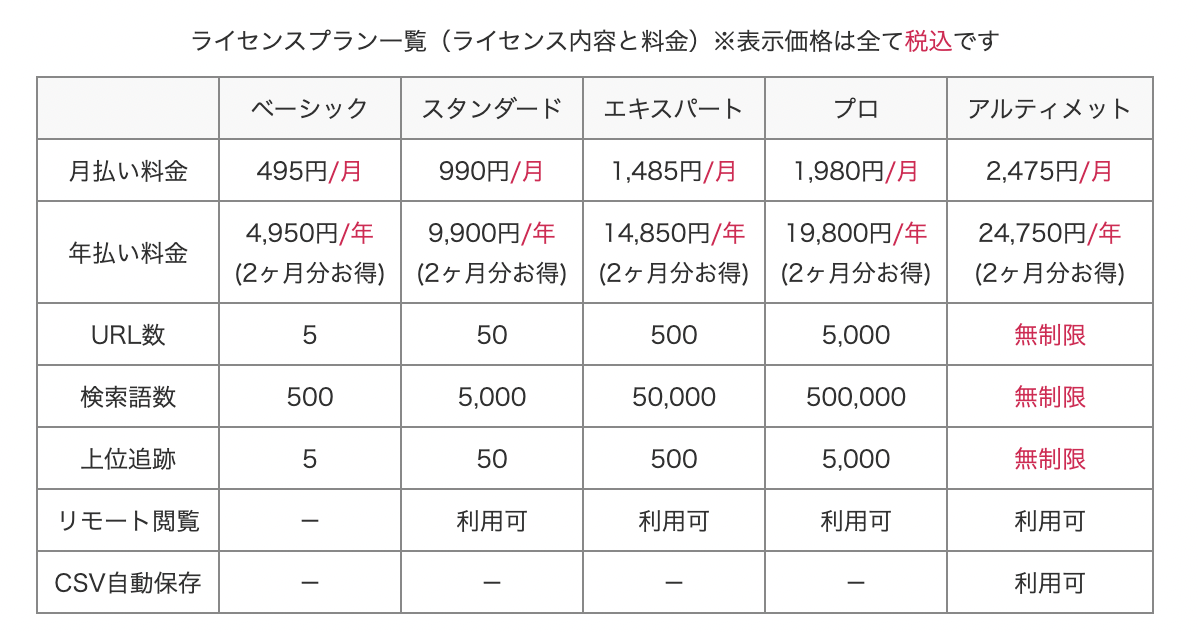

GRCの料金プラン

こちらがGRCの料金プランです。

内容を見ると明らかにRankTrackerよりもGRCのほうがお得です。

うーん、これはお得。と改めて見ていて思いました。

【注意!】MacユーザはGRCを利用できない

すごく良さそうなGRCですが、残念ながらMacでは使えません。

正確にはMac上に仮想環境を構築して、その上で動くWindows上でなら動くと思いますが、わざわざそこまでやるぐらいならRankTrackerを使ったほうが良いです。

(そもそもWindows使う上で、そちらのライセンス料もかかるので、結果的に費用がかかります)

GRCはMacでも使える、というブログを見かけますが、これらのブログの情報はたいてい

- 情報が古い

- 仮想環境上のWindowsでやる前提

になっているので、注意が必要です。

上記ページが公式サイトに存在しますが、このやり方は現在のMacでは実現できません。

現在のmacOSではここで説明されているWineはまともに動かなくなっているので、実現はできないと思います。

私は別の作業でこのWineについて一時期触れていましたが、結局、現状のWineではどう頑張ってもうまく動かないため挫折しました。

もしかしたらうまく動かせる方法が残されているかもしれませんが、それをやるぐらいであればMacユーザはRankTrackerをインストールして動かしていたほうがたくさんの時間を無駄にせずに済みます。

検索順位を調べるためのツールをPythonで自作してみた。

さて、ここまでRankTrackerとGRCという有名な検索順位チェックツールについて書いてきました。

このように検索順位を調べるためのツールというのは色々と出ていますが、単純に 指定したページ に対する 特定のキーワードの順位 を調べるだけならPythonなどを使って簡単に調べられそう、と不意に思い立ち、自作してみることにしました。

ちなみにこのようなツールは既に自作されている方がいましたが、Googleの検索結果画面のアップデートにより動かなくなっているものばかりでした。そして、このツールもそのうち動かなくなると思います。

もし使いたいけど動かないという場合は、動くようにメンテンナンスしようと思うのでコメントください。

また一応動作が問題ないことはこちらで確認していますが、利用は自己責任でお願いします。

なお、コード作成の際には上に書いた先人たちの処理も参考にさせてもらっています。感謝です。

ツールの動作環境と注意点

なお、このツールはGoogle検索結果の順位のみを調べるツールとなります。

現段階ではまだ試作版的な立ち位置なので、もし利用する際は下に貼ったソースコードをご自身のPC上にコピペして利用してもらうことになります。

ある程度、うまく動くようになったらGitHubとかでドキュメントつきで公開しようとか考えていますが、いずれGoogleのアップデートで動かなくなると思うので、そこの運用をどうするか次第。

利用するにはターミナル(黒い画面)からコマンドを実行する必要があります。

また、筆者の環境はmac環境であり、他の環境からテストをしておりません。

os固有の機能は使っていないと思うので、Windowsでもたぶんそのまま動くような気がしますが、動かなければコメントいただければ、動くように修正しようと思います。

検索順位チェックツールのコード

まずは下記のコードを main.py など適当なPythonスクリプトファイルにコピペしてください。

from bs4 import BeautifulSoup import requests import random import time import pandas as pd import datetime import json import logging # class selector SELECTOR = 'C8nzq' # user agent USER_AGENT = 'Mozilla/5.0 (Linux; Android 6.0.1; Moto G (4)) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.128 Mobile Safari/537.36' def get_headers(): headers = { 'User-Agent': USER_AGENT } return headers def get_target_site_title(target_url): target_site = requests.get(target_url, headers=get_headers()) target_soup = BeautifulSoup(target_site.text, 'html.parser') title = target_soup.find('title').text return title def get_search_url(keyword): return 'https://www.google.co.jp/search?hl=ja&num=100&q=' + keyword def search_index(keyword, target_url): try: title = get_target_site_title(target_url) res = requests.get(get_search_url(keyword), headers=get_headers()) soup = BeautifulSoup(res.text, 'html.parser') urls = [a.get('href') for a in soup.findAll('a', class_=SELECTOR)] today = datetime.date.today().strftime("%Y/%m/%d") url_index = 0 for url in urls: if target_url not in url: url_index += 1 else: url_index += 1 break series = pd.Series([today, url_index, target_url, title, keyword], index=df.columns) return series except: pass if __name__ == "__main__": logging.basicConfig( level=logging.INFO, format='%(asctime)s %(levelname)-8s: %(message)s' ) logging.info("Start!") config_file = './config.json' with open(config_file, 'r') as f: json = json.load(f) urls = json['urls'] keywords = json['keywords'] df = pd.DataFrame(columns=['date', 'rank', 'url', 'title', 'keyword']) for url in urls: logging.info("Check URL: " + url) for keyword in keywords: logging.info("Check keyword: " + keyword) print("============") series = search_index(keyword, url) print(series) df = df.append(series, ignore_index = True) random_sleep_time = random.randint(70,100) print("============") logging.info("Wait...: " + str(random_sleep_time)) time.sleep(random_sleep_time) file_name = 'rank_' + str(datetime.date.today().strftime("%Y%m%d")) + '.csv' df.to_csv(file_name) logging.info("Generate csv file: " + file_name) logging.info('Finish!')

実行するためにはいくつかのライブラリをpip経由でインストールする必要があります。

インストール必要なライブラリは下記の3つです。

- beautifulsoup4

- requests

- pandas

そのため、pipコマンドを使って下記のようにインストールします。

pip install beautifulsoup4 requests pandas

自作の検索順位チェックツールを動かすまでの設定

次に実行前にチェック対象のページURLと、チェック対象のキーワードを設定する必要があります。

コピペしたPythonコードと同じディレクトリに config.json というファイルを作成して、下記のコードをコピペして、自分の調べたい内容に適宜書き換えてください。

urlsと書かれている配列の中にチェックしたいページURLを格納していきます。keywordsと書かれている配列の中に調べたいキーワードを格納していきます。- 記載された

urls内のURLに対して、keywords内のキーワードをすべてチェックしていきます。- つまり下記の場合だと、ページURLが2つに対して、keywordsが5つのため、計10回チェックをかけることになります。

{ "urls": [ "https://shinshin86.hateblo.jp/entry/2021/03/10/083147", "https://shinshin86.hateblo.jp/entry/2021/04/26/111413" ], "keywords": [ "Gatsby SEO対策", "Gatsby SEO", "サイト SEO対策", "サイト SEO", "SEO対策" ] }

ツールの実行

config.json を準備し終えたら、準備は以上です。

下記のコマンドでPythonスクリプトを実行していきます。

(ここではPythonスクリプトファイルを main.pyとしています)

python main.py

ちなみにこのスクリプトはPython3系を動かすことを前提にしています。

私の環境ではPython3系の実行は python3 コマンドが行ってくれるので、下記のコマンドでスクリプトを走らせています。

pythonコマンドだとエラーになるという方は、下記のコマンドで打ってみてください。

python3 main.py

後はひたすら待ちます。

というのも、このツールのようにプログラムからGoogle検索結果にアクセスする場合、あまりに感覚が短ったりすると、Google検索結果で画像認証(reCAPTCHA)が出るらしいので、結構な待ち時間を間に挟むようにしています。

そのため、プログラム終了までかなり時間がかかるので、ターミナルは開きっぱなしのまま、別の作業をしていたりすることをおすすめします。

なお、スクリプトを実行すると下記のようなログがターミナルに出力されます。

$ python3 main.py 2021-04-30 10:51:38,203 INFO : Start! 2021-04-30 10:51:38,208 INFO : Check URL: https://shinshin86.hateblo.jp/entry/2021/03/10/083147 2021-04-30 10:51:38,208 INFO : Check keyword: Gatsby SEO対策 ============ date 2021/04/30 rank 16 url https://shinshin86.hateblo.jp/entry/2021/03/10... title 【Gatsby の SEO対策】Gatsby + Netlifyで運用しているサイトで意図し... keyword Gatsby SEO対策 dtype: object ============ 2021-04-30 10:51:39,506 INFO : Wait...: 71 2021-04-30 10:52:50,512 INFO : Check keyword: Gatsby SEO ============ date 2021/04/30 rank 64 url https://shinshin86.hateblo.jp/entry/2021/03/10... title 【Gatsby の SEO対策】Gatsby + Netlifyで運用しているサイトで意図し... keyword Gatsby SEO dtype: object ============ 2021-04-30 10:52:51,630 INFO : Wait...: 98 2021-04-30 10:54:29,636 INFO : Check keyword: サイト SEO対策

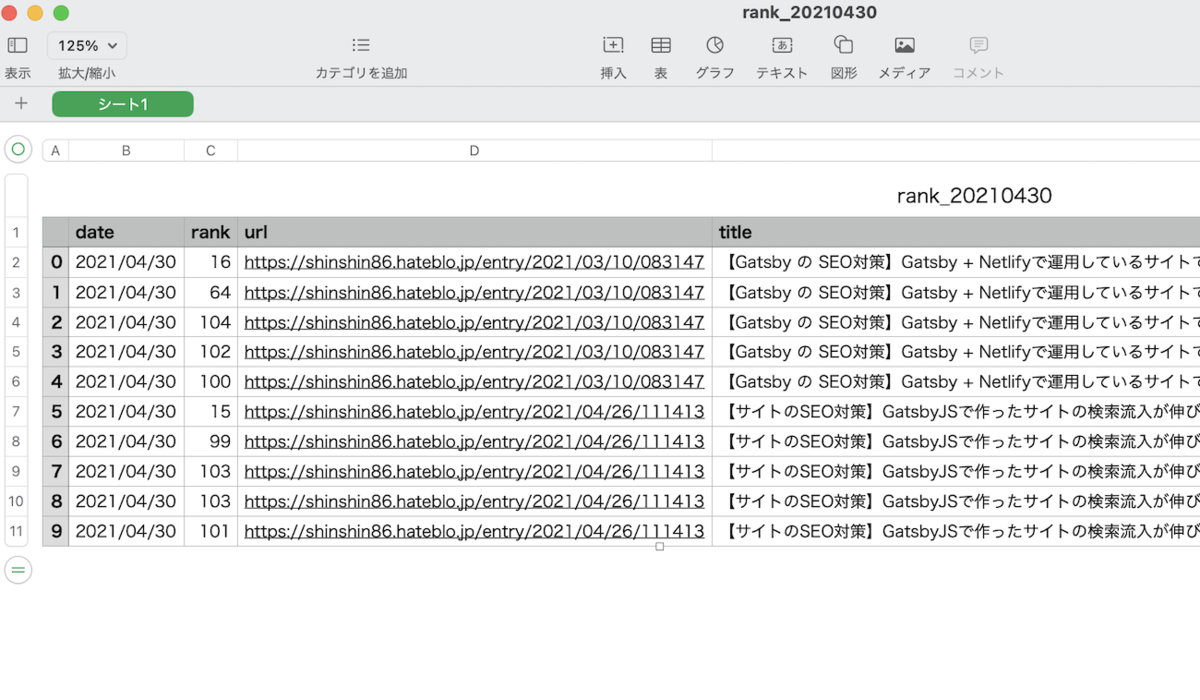

そして、プログラムが完了すると同じディレクトリ内に日付がタイトルに入った csv ファイルが生成されます。

(rank_今日の日付.csv というファイル名で生成されます。同じ日にプログラムを2回実行してしまうと、元のファイルを上書きしてしまうので注意)

csvファイルの中身はこんな感じ

windows環境ならExcelとかで同じように開けるのかと思います。

(記憶が曖昧なので間違っていたらすみません)

ツールの紹介は以上です

このような感じで1日1回実行しながら、指定したキーワードでの検索順位がチェックできます。

先ほども書きましたが実行完了までは時間がかかるので、別の作業の裏で動かしておくような形が良いかもしれません。

【サガフロリマスター】サガフロンティアの最強忍者、パープルシャドウについての攻略メモ(裏ボス)

これは主に自分のために書き残した備忘録となります。

サガフロリマスターで戦える、チート級に強い裏ボス(?)のパープルシャドウ攻略のためのメモとなります。

最初に書いておくと、内容が不正確な可能性もあるので、もしご覧になる方は参考程度にしてください。

(パープルシャドウの詳しい仕様は、サガフロに詳しい方々の情報を参考にしたほうが良いと思います。)

最初に追記

サガフロンティアリマスターの発売から時間も経ち、パープルシャドウ攻略に関する動画解説もYouTube上に出回ってきているような印象を受けます。

筆者はあまりそちらはチェックできていませんが、こちらの攻略メモと併せてYouTube動画なども一緒にチェックしてみると良いかもしれません。

記事の目次

今回書いていく内容は以下のとおりです。

サガフロリマスターでチート級に強いパープルシャドウと戦う方法

サガフロリマスターではいずれかの主人公で一度ゲームクリアすると、ヒューズ編が遊べるようになり、クリアした主人公の話を今度はヒューズ視点から遊べるようになる。

ヒューズ編では他の7人の主人公を仲間に加えられるようになるが、ラスボス前までにそれぞれの主人公を仲間にしておくと、ラスボスと戦闘する前に各主人公のラスボスとそれぞれ戦えるようになる。

そしてそれぞれの主人公のラスボスを倒した状態で、本来のラスボス(ヒューズ編を始める時に選択した主人公のラスボスのこと)と戦闘を行うと、そのラスボスが強化された状態で戦うことができる。

これがヒューズ編で戦える最強のラスボスとなる。

ここについては以前も似た投稿をしている。

そしてヒューズ編で最強状態のラスボスを倒すと、リマスター版の開発室へ行くことができ、そこでバトルの移植を担当されたというチート級に強い忍者、パープルシャドウと戦闘することができる。

チート級と書いたが、本当にズルいという感想しか思い浮かばないぐらいに強い忍者となっている。

この忍者、行動パターンが複雑で、こちらの行動次第では全滅必須の攻撃を仕掛けてくるので、挑戦していると、こんなの勝てるわけないじゃん...という気持ちになってくる。

今回このパープルシャドウの行動パターンや仕様などをこちらにメモする。

最初にも書いたが、内容が不正確な可能性もある。現時点で自身が把握していることだけをメモしている形だ。

パープルシャドウのHPと逃走について

パープルシャドウは一定のダメージを与えると花火を打ち上げて逃走する。

他のボスのように撃破演出は入らず逃走するので、本当にこれで倒せたのか? という気持ちになるが、たぶんこれは撃破扱いで良さそう。

撃破すると、次に戦うパープルシャドウはHPが高くなっており、前回の戦闘よりも難易度が上がっている(ここについては後述する)。

なんとなくだが、撃破回数とHPの関係は下記の通り

- 1段階はHPが10万ぐらい?

- 花火が1発上がって終わり(逃走)

- 2段階(1度撃破)だとHPが12万ぐらい

- 花火が5発上がって終わり(逃走)

- 3段階(2度撃破)だとHPが14万ぐらい

- 花火が20発上がって終わり(逃走)

バトルスタート時の乱れ雪月花の回数について

上に書いたように撃破回数に応じてHPが変わるが、他にもバトルスタート時の乱れ雪月花の回数が変わる。

ちなみにヒューズ編で最強状態のラスボスを撃破した回数に応じて、パープルシャドウの強さが変わるという噂もあるようだが、これについては不明。

パープルシャドウの特徴・行動パターンについて

パープルシャドウの行動パターンは複雑すぎて、あまり把握できていない。

- ダメージ量が減少していくことについて

- パープルシャドウはダメージを与えていくと、与えられるダメージ量が減少していく。

塔を組み込んだ連携で数万単位のダメージを与えても、以降同じ攻撃をしても、ダメージ量が大幅に激減している。このことから同じ攻撃、または同属性などで攻撃していくとそれに対しての防御力が上がっていくのかもしれない。もしくは単純に与えたダメージ量に応じて防御力が固くなっていっている可能性もある。あくまで想像の域を出ない話となるが、とにかく後半は忍者が固くなって、まともにダメージが入らない。盾の回避対象となる攻撃はガードされる可能性もあるので、時間触や跳弾を連携に組み込んだ攻撃でダメージを与えていくしかない。

- パープルシャドウはダメージを与えていくと、与えられるダメージ量が減少していく。

- パープルシャドウの攻撃について

- おそらくだが、こちらが与えたダメージ量や連携数に応じて、次のターンの攻撃の激しさが変わっているような気がする。塔を連携に組み込んだ攻撃とかを行うと、次のターンは即死級の攻撃が来る(強力な攻撃を複数回仕掛けてくるレベルなのでリヴァイヴァがないと全滅する)。5人連携を行ったときも攻撃が激しい気がする。逆にこちらの攻撃が貧弱なときは向こうの攻撃も優しい気がする。でも、はっきりした規則性があるかはわからない。あとパープルシャドウが戦闘開始から使ってくる乱れ雪月花を幻魔でカウンターかけていくのも、次のターンの行動が激しくなる気がする。

- オーバードライブはペナルティあり

- オーバードライブを使うとペナルティをくらい、ダメージが入らなくなる。これは連携をしても同じ。結論、オーバードライブを使った攻略はできない。

- タイムリープもペナルティあり(ただし条件付き)

- 盗賊の指輪を使って全員隠れた場合もペナルティがあるらしいが、内容は不明。

- 後述するがブルーにリヴァイヴァ役をお願いする関係で、いずれにせよ盗賊の指輪は使わない。ただ、戦闘開始時の乱れ雪月花を回避できるのは魅力的そうだが...

- 奥の手

- 序盤から

塔などを交えた連携で大量のダメージを与えていると、パープルシャドウがセリフを喋る(下記の画像参照)。このセリフを喋ると、HPが全回復するようで、例えば3段階目の強さであれば、再びここから14万のダメージを与える必要が出てくる。この奥の手は連携を使って序盤から大ダメージを与えたことに対するペナルティ的な立ち位置らしい。正確な奥の手の発動条件は不明。

- 序盤から

パープルシャドウの攻略メモ

ヒューズ編でブルーを選択してクリアしてパープルシャドウに挑む。

ブルーにはリヴァイヴァ役になってもらう。パープルシャドウの攻撃は強力すぎるので、リヴァイヴァ前提で攻略を考えていくことになる。

パープルシャドウ戦のパーティ

ブルーは必須。リヴァイヴァ役。

メサルティムも 生命の雨 役でほしいところ。でも、火力を優先で別のキャラでも良いかもしれない。悩む。

あとは、好みのメンバーで。ロボもいいし、序盤から一気に押しかけるなら塔役も複数人ほしい。

塔を絡ませた連携で一気に押しかけるのもありといえばあり。

戦闘前に覚えておきたい見切り

戦闘前に見切りを覚えておく。覚えておきたい見切りは以下の通り。見切りがないと耐えられない。

- 烈風見切り

- 剣みたいな見た目の

グリランドリーが使ってくる。クーロンの下水道で出会えた。

- 剣みたいな見た目の

- ネット見切り

- 同じく

グリランドリーから、見切れる

- 同じく

- 地響き見切り

シュリーカーから見切れる。生命科学研究所で出会える。- が、これは

ジェットブーツで防ぐ方法で良いかも。

- パウダー見切り

- 同じく

シュリーカーから見切る。ちなみに見た目は謎の植物みたいな形したやつ。

- 同じく

戦闘前の装備

とりあえずヒューマンには、ここらへんの装備を適宜装備させるようにする。

最適な装備はわかりません。

攻略メモ

- 戦闘開始後は乱れ雪月花が必ずくる(攻撃回数はパープルシャドウの強さによって変わる)

- 幻魔でカウンターしてもよいが、次のターンの行動が激しくなる気がするので、普通に防御でも良いかも

- ちなみにHP999で防御してぎりぎり生き残れるぐらいのダメージが来る

- ブルーは味方にリヴァイヴァをかけていく

- そして、誰にかけたか途中でわからなくなる

- ダメージは基本連携で与えていく

- このときに、

塔などを加えて大ダメージを狙うと次のターンの攻撃が辛くなる傾向ありだが、一気に押しかけてしまうのもあり。その後のダメージで生き残れるかは運になる? - あと一度

塔を打ち込むと、その後の塔のダメージが入らなくなる可能性がある。 - 上にも書いたが盾による回避対象の攻撃は回避される可能性があるため、

時間触や跳弾を連携に組み込んだ攻撃でダメージを与える。あと時間触で QUIを下げられるため、これはなるべく使っておきたい。

- このときに、

- 戦闘が長引くと、

WP/JPが足りなくなってくるので、辛い。やはり先手必勝で畳み掛けるのが良いか。

以上、メモ書きでした。

Google Search ConsoleからURLのインデックス登録をリクエストしてもGoogleの検索結果に出てこない場合

インデックス登録をしたのにGoogle検索結果に出てこない

Google Search ConsoleからURLのインデックス登録をリクエストしてもGoogleの検索結果に出てこない場合がある。

このケースは時折、起きるときがある。

インデックス登録をリクエストすると、大抵は再度URL検査を行うと、既にGoogleのインデックス登録済みとなっているのだが、このようなケースでは再度URL検査をしても、インデックス登録がされていない状態となっているとGoogle Search Console上で告げられる。

Google Search Consoleの公開URLをテストで問題がないページでもインデックス登録が行われないケースがある

Google Search ConsoleではURL検査を行ったときに、公開URLをテスト という機能があり、実際に指定したURLのページに問題がないかを前もって確認することができるが、この確認の際に問題がないURLの場合でも(※)、検索結果に出てこないようなケースはある。

※Googleでインデックス登録できる、と判定された場合でも、Googleのインデックス登録が行われないというケースだ。

ちなみに、このようなケースはGoogle側でも ある とドキュメントに記載されている。実際の記載は下記のページにある。

URL 検査ツール - Search Console ヘルプ

下記が上のページの引用となる。

有効なテスト結果が得られたページは、必ずインデックスに登録されますか?

いいえ、されません。このテストでは、Googlebot がインデックス登録のためにページにアクセスできることのみが確認されます。ライブテストの判定が有効または警告であったとしても、そのページがインデックス登録されるには、さらに他の条件を満たす必要があります。次に例を示します。 ページに手動による対策や法律に関する問題が含まれていないこと。 ページが、インデックスに登録された別のページと重複していないこと。固有のページであるか、同様のページセットの正規バージョンとして選択されている必要があります。 インデックス登録されるには、ページの品質が十分に高くなければいけません。

インデックス登録できると判定されたページなのに、実際のGoogleの検索結果に出てこない場合の原因

では、なぜGoogleの検索結果に出てこないかという話だが、まずは URLが重複しているとか、複数のURLでアクセスできるとか、そのような問題はない という前提でここは話をすすめる。

もしこのような問題が考えられる場合は、まずはそちらの問題を解消していく必要がある。

これらの問題については下記のドキュメントに記載されている。

では、ここからが本題となる。

なお、ここからの内容は自身の主観も入り混じっていることに注意してほしい。

これまでこのようなケースをいくつか体験してきて、実際に原因を探った上でたどり着いた一つの仮説レベルである。

コンテンツが似ていることが原因!?

具体例を出して説明しようと思う。

下記の投稿は昨日書いたものだ。

たいていブログの投稿を行い、インデックス登録をリクエストすると、このブログの場合、早ければ数時間でGoogle検索結果に載る。

だが、こちらの記事は一晩経ってみても、Google 検索結果には載っていなかった。

そればかりか、再度URL検査をしてみても、インデックス登録されていない状態とGoogle Search Console上では表示されていた。

実際に上の記事に関連するワードで検索してみても、検索結果には出てこない。が、代わりに下記の記事がヒットしていた。

こちらの記事も先ほどの記事も、コンテンツの内容が似通ってはいる。

そしてGoogle検索に関するドキュメントではこのような場合、完成度が高いページの方を正規としてみなして、もう片方のページについては重複したページと判断する、というような記載が上に貼ったGoogleドキュメント内にある。

実際にその記述を下に引用する。

Googlebot は、サイトをインデックスに登録する際、各ページの主なコンテンツを特定しようとします。同一のサイト内に、同じものを扱っていると思われるページが複数見つかった場合、Googlebot では、最も完成度が高く有用であると判断したページを選び、そのページを正規と見なします。この正規ページが定期的に最も頻繁にクロールされることになり、重複したページについては、サイトに対する Google のクロールの負荷を削減するためにクロール頻度が下がります。

今回の場合、これらのブログ記事の一つのテーマとして ペラサイト というのが挙げられる。

このテーマで被っているために、インデックス登録されていないのではないか?と私は考えている。

コンテンツが被っている場合の対応策は?

この対応策についてだが、ひたすら待つしかなさそうというのが自身の結論である。

実際に何もせず待っていたら、いつの間にかインデックス登録されていたというケースがある。

こちらの記事も書いてから数日経っても、インデックス登録は行っても、後日URL検査を行うとインデックス登録されていない状態 となっていた。

諦めて放置していたが、するといつの間にかインデックス登録が完了してGoogleの検索結果に出てくるようになっていた。

というわけで、この問題については一旦放置で待ってみるというのも良いかもしれない。

実際のところ、コンテンツが似ているものでも、公開してから数時間でそれぞれのサイトが正常にインデックス登録されているケースもあるので、ここらへんはGoogleのシステムの他の要因で起きているのかもしれない。

(結局、これらのことは憶測の域を出ないな...とここまで書いていて思った)

もし同じような問題で悩んでいる方がいましたら、参考になれば幸いです。

【2021年版】費用を年1円に抑えながらペラサイトを運営する方法

費用を年1円に抑えるなんてことは可能なのか?

タイトルがかなり釣りっぽいタイトルになっている気がしたので、最初に結論だけ述べておくと、これは現実に可能である。

なお、後述するが、2年目以降は1,000円代に支出が増える。が、それでも十分安い。

もし作成したペラサイトがヒットする様子がなければそのまま1年目の段階で解約すれば良いので、その場合はドメイン代については1円で済む計算となる。

実際、私自身はペラサイトではないが、とあるウェブツールを1円という運営費で運用していた。

やり方を下に述べる。

- お名前ドットコムで

.workドメインを取得する- 最初の1年目は1円で契約可能だ。支出となる部分はここのみとなる。

- なお2年目以降は1円ではなくなるので、だいたい1000円代の支出に増える。が、それでも十分安い。

- あと、たしかお名前ドットコムだと

Whois情報公開代行サービスは別途費用が取られたような気がするので、それで プラスアルファの費用がかかるかもしれない(一応、下に参照リンクを貼っておいた)。

- ペラサイトのホスティング環境にはNetlifyを利用する

- Netlifyの無料プラン内で収まるようにサイトを運営していくわけだが、サイトがそれなりにヒットしないとこの無料プランに収まらなくなるという事態にはならない。

- しかもNetlifyの無料プランの場合、巨大なサイトを構築する場合などはサイトのビルド時間に月単位で上限が決まっているため、この上限に引っかかるケースも出てくるが、ペラサイトならビルド時間は殆どないので、気にする必要がない。

- つまり、しっかりと収益が出せるようになるまでは無料プランで収められることができる

Netlifyのプランについては下記のキャプチャも参考にされたし。

(この赤枠で囲っている Starter プランというのを利用する。私も現在このプランを利用している)

もし .work ドメインではなく .com ドメインを選びたい場合でも年間の費用は 1,500円ほどだ。

お名前ドットコムのWhois情報公開代行サービの費用について

Whois上で表示される情報を、お名前.comの情報に代えて掲載するサービスです。 通常「1,078円/年」のところ、ドメイン登録と同時にお申し込みいただいた場合、無料の「0円/年」でご利用できます。

リンク先を見てみると、このように書いてあるので、実質無料?

私自身もお名前ドットコムを利用しており、.work ドメインも所有していたが、実質1円で済んでいたので、ここの料金はかからないかも。

以上、ネタばらしである。

最初に

だいぶ前にこのような投稿を行った。

どうやらこの投稿の影響で、ペラサイト関連の検索流入がこのサイトにも流れてきているようだった。

また、ペラサイト 費用 や ペラサイト ドメイン代 などで検索してきている方もそれなりにいるようだったので、ここでは主にペラサイトの費用やドメイン代など、運営費に関する内容について書いていこうと思う。

さらには、せっかくなので、もしペラサイトを運営する場合に、支出をドメイン代のみに抑える方法についても書いていく。

これは上のポストにも書いた内容と被るのだが、上では結構色々と文章を長たらしく書いてしまったので、こちらでは要点をまとめて書いていこうと思う。

ペラサイトを運営する場合の費用は?

それでは、まずペラサイトを運営する場合の費用について書いていこうと思う。

ペラサイト運営時のドメイン代はいくら?

ペラサイトのドメイン代といっても、ドメインの契約方法については普通のブログと変わらない。

そのため、基本的にはドメインを契約するために利用するサービスの料金表を見れば、おのずと1年単位のドメイン費用は算出できる。

例えば上に貼ったお名前.comであれば、.com ドメインの料金は年単位1500円行かないぐらいだ。

しかも1年目の契約の場合は割安になる可能性もあるので、実質さらに運営費は安く済ませられる。

他にも .work ドメインなどは1年目は1円で契約ができるので、例えば1年間ペラサイトの運営を行ってみて思うように行かなければ解約することもできる。

そのため、実質ドメイン代に関する費用は殆どないと行っていい。

.workドメインはSEOに不利?

ちなみに余談だが .work ドメインは過去に自身も所有していたことがあり、ちょっとしたWebサービスをこのドメイン上で運用していた。

このサービス自体はそれほどヒットしなかったこともあり、このドメインは既に解約してしまったのだが、 .work ドメインでも普通にGoogleの検索インデックスに登録されていたし、他に所有している .com ドメインと比べてSEO的にもそれほど差はなかったように思う。

そのためドメインの文字列が .workであることを特に気にしなければ、 .work ドメインでも問題はないと思う。

ペラサイト運営にかかるサーバ代

ペラサイトといえど、基本的なやり方としてはレンタルサーバ上でホスティングするので、月に500円ほどは運営費がかかる。

ネットで調べてみると、年間6,000円ぐらいに抑えられたりもするようだが、いずれにせよサーバ代は安く見積もっても、これぐらいはかかると考えていたほうが良さそうだ。

ちなみに後述するが、今回私が書く内容であれば、この月々のサーバ代を0円にできる。

(というか、最初に結論のところでネタばらししてしまっているが)

費用を年1円に抑えながらペラサイトを運営する方法

ではここからが本題だが、ペラサイトの費用を年間1円に抑える方法をこちらに書いていく。

最初にも書いたが、やることは下記のとおりである。

- お名前ドットコムで

.workドメインを取得する (1年目なら1円で運用可能。2年目以降は1000円とちょっと) - サイトのホスティングはNetlifyで行う。それなりにサイトへの流入が増えない限りは無料で運用可能。

- 私自身複数のサイトをNetlifyで運用しているが、未だに無料プランだ(残念ながら...)

この運営方法を行うために下記のアカウントがそれぞれ必要になる。

- GitHubアカウント

- Netlifyアカウント

また HTML, CSS, JavaScript などの基礎的な知識と、Gitを扱えることが条件だ。

ここでプログラマーじゃない方はウッとなるかもしれないが、これらの知識を取得できれば、このやり方を使えるだけでなく、今後サイト事態の運営スキルにも直結する技術なので、これを機に取得しても良いかもしれない。

上に書いたそれぞれのアカウント作成方法と、GitやHTMLなどのスキル取得方法については検索すれば、それなりに情報がたくさん出てくると思うので、ぜひ調べてみてください。

(このページで解説を行うと、ものすごい量になってしまうので書きません)

ペラサイト用のテンプレートはHTML5 UPを利用する

ペラサイトに利用するテンプレートとしてHTML5 UPを利用する。

詳細は上記サイトから確認してもらいたいが、これはCreative Commons Attribution 3.0 License で利用できるHTMLのテンプレートだ。

好みのテンプレートをダウンロードして、後はコンテンツを書き込んでいくだけ。

メタ情報関連も忘れずに入力。

コンテンツを作り終えたら、GitHubにリポジトリを作成する。

GitHubのリポジトリは現在はプライベートリポジトリも無制限で作成できるようになっているので、コンテンツを公開する意図がなければプライベートリポジトリで作成しておくとよいだろう。

あとはNetlify側でこのリポジトリを連携して、サイトを公開。

公開したサイトに独自ドメインの設定を行えば完了である。

最後は駆け足の説明となってしまったが、GitHub関連の操作や、Netlifyでのサイトの公開方法や独自ドメインの設定方法などはGoogle検索で検索すればいくらでも出てくるので、ここらへんはぜひ調べてみてほしい。

また詳細なセットアップ方法についてはこちらにも書いてあるので、こちらも併せて参照していただけたらと思う。

【2021年にも使える!】ペラサイトを半日で作って独自ドメインでリリースまで行う方法(費用はドメイン代のみ) - at backyard

費用を年1円に抑えるのは再現性のあるやり方

今回の投稿は以上となる。

サイトの運営費用を1年間で1円に抑える、という言葉はこれだけ聞くと、まるで魔法の言葉にようにも聞こえるが、このやり方自体は自身も既に行っていたことだし、同じようにやれば誰でも再現できる方法である。

(2年目以降は1,000円代に支出は増えるものの、それでもかなり安いし、サイトがヒットする様子がなければそのまま解約すれば良い)

そのため、釣りタイトルに見えて、意外と釣りタイトルではない。

.com ドメインなどもプレミアムドメインでなければ1,500円ほどで利用できるので、年間1,500円ほどの出費ならばかなり支出を抑えられるのではないだろうか。

【宣伝】簡単にAMP対応のウェブサイトを作成できるHabanero Bee

最後に自身が作成したツールの宣伝をさせてもらう。

もしあなたがペラサイトをこれからやろうか迷っているとする。

ペラサイトも良いが、普通のウェブサイトも捨てがたい。

普通のウェブサイトを運営するでも良いけど、なるべくサクッと作りたいなーなどと考えているなら、Habanero Beeはおすすめの選択肢になるかもしれない。

これはGoogle のスプレッドシートを利用して簡単にAMP対応のサイトを作成するツールだ。

今回の投稿で説明した GitHub と Netlify の組み合わせでサイトをホスティングするようになっていて、ここに書いた年1円運用も可能な構成となっている。

もちろん、 GitHub と Netlify それぞれのアカウントがあることと、それぞれの使い方を理解していることが条件ではあるが、サイトの労力をなるべく抑えて作成していくという観点から見れば有力な選択肢ではある。

私はこのHabanero Beeの開発を行いながら、自身でもいくつかのサイトをHabanero Beeでホスティングしているが、サイトを公開してからだいたい2~3日ぐらいでGoogle AMPキャッシュに乗っかっている印象を受ける。

利用しているツールにもよるが、ウェブサイトのAMP対応はそれなりに労力がかかるケースもあるので、最初からAMPに対応している分、AMPキャッシュにも早く乗れるし、AMP対応の労力もかけなくて済むのは悪くないことだと思う。

というわけで、もし興味ある方は是非チェックしてみてください。

【サイトのSEO対策】GatsbyJSで作ったサイトの検索流入が伸び悩んでいて色々と対策してみた話

目次

- 目次

- 最初に結論

- GatsbyJSで作ったサイトの検索流入が伸び悩んでいる

- 問題の原因は、そもそも狙うべき検索ワードにあった

- 検索キーワードに競合が多い場合は、流入対象とするキーワードをずらすようにする

- SEO対策の結果

最初に結論

文章が長くなりそうなので最初に結論を述べておく。

- Gatsby自体が悪いわけではなかった。

- そのサイトのSEOの方向性自体が間違っていたというだけ。

- 要は競合が強すぎるワードで検索インデックスに載せようとしてた(そのせいで検索順位が90位代を常にフラフラするはめになっていた...)

- サイトの検索流入に結びつける検索ワードの見直しと、流入のためのページを作成することで、当日中にGoogleの検索インデックスに載ったことを確認

- どれぐらい検索流入が伸びていくかは今後監視していく

- もちろん、適切なSEO対策を施していることがここでは前提となっている。

なお、ここでは扱っているサイトの具体的な名前はこのポスト内では出していない。

別に個人的なサイトだから出してもいいのだが、単純に現在行っている施策のみでどれぐらいSEO効果が現れるかを検証したい気持ちがあるので、出さないようにしている。

(意外とこのブログもアクセスが増えてきたためか、リンクを貼ることによってSEOに影響が現れるようなことが何度かあった。一応そういう要素は除外したい)

GatsbyJSで作ったサイトの検索流入が伸び悩んでいる

GatsbyJSで作成したサイトの検索流入が伸び悩んでいたので、この土日は色々と対策を考えて実践していた。

土日の半分はGatsbyでできていたようなもので、ひたすらSEO対策のことを考えながらJavaScriptのコードをいじっていた。

そもそも自身が作成しているGatsby製のサイトで、検索流入を意識したサイトというのはまだそれほどないのだが、他のサイトに比べるといかんせん検索流入数が少ない...

それなりに検証も行ってみたが、私自身が作成している AMP対応のサイトを簡単に素早く作成できる Habanero Bee のほうが、Googleの検索インデックスに載るスピードは早いように感じた(あくまで個人の体感)。

そんなこともあり、もしかしてGatsbyは実はSEOに弱いのでは?という嫌な予感にここ最近支配されていた。

先に行っておくと、私はGatsbyは好きで、とても便利なツールだと思っている。

WordPressのようにプラグインを追加していくことで欲しい機能も追加できるし、細かいところでカスタマイズしたければ直接コードをいじっていけるところも魅力的だ。

また静的サイトとしてホスティングできるので、Netlifyの無料プランなどで利用すれば、WordPressのように毎月のサーバ台が発生しないのも魅力的。

セキュリティ面でもリスクが少ないので、私としてはGatsbyJSはとても便利なツールだと思っている。

なのだが、、、SEOが弱いのは結構致命的である。

似たようなことを書いている人はいないかと検索してみたが、SEO絡みのキーワードでGatsbyを検索してみても、サイトマップの作成やOGPの設定、サイトの表示スピード向上に関する話など、テクニック的な部分が多く、今回自分が欲しい情報というのは少なかった。

なお、このサイトではサイトマップの作成やOGPの設定などについてはすべて実施済みである。

パフォーマンスチューニングも実施済みで、上の画像が Lighthouse の結果となる。

これはサイトのトップページを分析したものだが、トップページにはそれなりに画像やコンテンツが用意されており、結構縦長のページになっている。

が、それでもこのスコアが出るのは、やはりGtasbyすごいと言わざるおえない。

さて、このような形で最低限のSEO対策は実施しているのだが、ほとんど検索流入が来ない。どころかGoogle Search Consoleで確認しても、Googleの検索結果にインデックス自体がされていないような状況だった。

(インデックス自体がされていないというのは語弊があるので、もう少し詳しく書くと、一応ページのインデックス自体はされているものの、検索ワードで検索結果に表示されている数が少なすぎる。Google Search Consoleを見ると、狙ったワードで検索結果に表示すらされていない、という状況なのだ)

問題の原因は、そもそも狙うべき検索ワードにあった

このような状況でかなり思い悩んでいたのだが、そもそもSEOの大前提として、どのワードで検索流入を狙うか?という基本的な部分に立ち返って考えてみたところ、このサイトで検索流入を狙いたい検索ワードが、競合が多く、しかも企業がガッツリ作っているようなサイトばかりだったのである。

単純に競合が多く、かつ強いので検索結果の上位に出てこないだけでは...?

そんな思いが頭をよぎり、早速検索ワード見直しの作業に入る。

検索キーワードに競合が多い場合は、流入対象とするキーワードをずらすようにする

ここでは例として、仮に狙っている検索ワードを レンジで簡単に作れる時短飯 とする。

レンジで簡単に作れる時短飯の情報を集めたサイトだ。

ただし、このようなワードにもし競合が多く、かつどれも強い方々だった場合、このワードを狙ったコンテンツを作成しても、しがない個人サイトでは検索順位的には勝てる可能性は限りなく低い。

そこでキーワードをずらすようにする。例えば下記のようなキーワードを検討する。

(これはあくまで例なので、これらのキーワードが実際に有効かは分かりません)

- レンジ調理を行っても栄養素は壊れない?

- レンジをきれいに保つための、簡単なレンジの掃除方法

- 時間が足りない人に送る、簡単タスク管理

- 帰宅後すぐにレンチンご飯できる、作り置きレシピ集

- レンチンだけで食べれるおすすめのレトルト食品

このように レンジで簡単に作れる時短飯 で検索してきそうなユーザが興味を持ちそうなワードを次々と出していき、その中で検索順位で上位に出せそうなワードでコンテンツを作っていくことを、検索キーワードずらし術という。(→ 今、私が命名しました)

これらのワードで検索流入があれば、本命コンテンツである レンジで簡単に作れる時短飯 に対してもリンクを貼るなどして紹介ができる。

例えば、レンジ調理を行っても栄養素は壊れないかを確認したい人は、レンジ調理を行いたいと考えている人だろうから、レンジで作れる時短飯にも興味がある可能性が高い。

このようにして検索流入を狙いたいワードに関連しそうなワードで、流入のための口を新たに設けることで、結果的に検索流入の総数を増やしていくことができる。

この手法を、自身のGatsbyサイトにも適用することにした。

新たに検索キーワードを設け、その検索キーワードの流入を狙うためにブログ記事を作成した。

ちなみにそのGatsbyサイトにはブログ機能がなかったため、急遽ブログ機能を実装した。

といっても、提供されているプラグインなどを組み合わせて利用し、少しだけ内部の実装を修正することで、この土日の間でブログ機能の実装は完了できた。

目次機能もつけたし、ブログ記事をカテゴリー分けする機能も実装し、カテゴリーごとのページが自動生成されるようにもした。

また、ブログ部分のページ構成については下記のように、各ページからそれぞれのページに移動できるような流れも意識した。

この画像の赤矢印の部分が、今回の対策での肝となる、サイトコンテンツへの新たな流入の口となる。

SEO対策の結果

まだ日にちが経っていないので、実際の効果を判定できるのは後々となるだろうが、今のところは新たに作成したブログ記事に関しては、狙ったワードで検索にヒットし始めている。

なお、検索順位は10位~20位代あたりにいる感じだ。

今後ブログ記事を増やしていくことで、この検索順位をどれぐらい上げているかが肝だと思うし、また、本命のコンテンツへの流入にどれぐらい貢献できるかも楽しみである。

いずれにせよ、SEO結果が微妙だった原因がGatsbyではなかったのは本当に良かった。

というか、完全に自分のせいです。Gatsbyさん、疑ってごめんなさい。。。